خرید هاست وردپرس ایران، یکی از گزینه های پیش روی کاربران که مشتاق استفاده از وردپرس هستند، می باشد، اما چرا باید از هاست وردپرس ایران استفاده کنیم؟

مزایای هاست وردپرس ایران چیست؟

هاست وردپرس ایران مزایای خاصی دارد که میتواند برای کاربران ایرانی مفید باشد:

- سرعت بالا: با میزبانی وبسایت در سرورهای داخلی، زمان بارگذاری صفحات بهطور چشمگیری کاهش مییابد، زیرا اطلاعات بهطور مستقیم از سرورهای نزدیک به کاربر ارسال میشود.

- پشتیبانی بهتر: ارائهدهندگان هاستینگ ایرانی ممکن است خدمات پشتیبانی به زبان فارسی و با آشنایی بهتر به نیازهای محلی ارائه دهند.

- هزینه کمتر: هزینههای هاستینگ داخلی معمولاً پایینتر از هاستهای خارجی است، بهویژه زمانی که به مباحث مالی و نرخ ارز توجه کنید.

- دسترسی آسان به قوانین و مقررات: قوانین و مقررات مربوط به اینترنت و دادهها در ایران ممکن است برای سایتهای محلی آسانتر باشد که بهطور مستقیم با قوانین داخلی همراستا شوند.

- پایداری بیشتر: با استفاده از سرورهای داخلی، احتمال وقوع مشکلات مربوط به تحریمها و محدودیتهای بینالمللی کاهش مییابد.

- سرویسهای بومی: ممکن است امکان استفاده از سرویسهای بومی و نرمافزارهای ایرانی که با هاستهای داخلی سازگاری بیشتری دارند، وجود داشته باشد.

این مزایا میتواند به عملکرد بهتر و تجربه کاربری بهینهتری برای وبسایتهای وردپرس در ایران منجر شود.

چرا باید هاست وردپرس ایران بخریم؟

خرید هاست وردپرس ایران برای وبسایتهای وردپرسی به دلایل متعددی میتواند انتخاب هوشمندانهای باشد:

- سرعت و عملکرد بهتر برای کاربران داخلی: اگر مخاطبان وبسایت شما عمدتاً در ایران هستند، خرید هاست وردپرس ایران به دلیل نزدیکی سرورها به کاربران، سرعت بارگذاری صفحات وبسایت شما را بهبود میبخشد.

- پایداری در برابر تحریمها: هاستهای خارجی ممکن است به دلیل تحریمها دسترسی شما را محدود کنند یا خدمات خود را قطع کنند. استفاده از هاست داخلی خطر این محدودیتها را کاهش میدهد.

- پشتیبانی فنی به زبان فارسی: ارائهدهندگان هاست ایرانی معمولاً پشتیبانی فنی به زبان فارسی و با درک بهتر نیازهای کاربران داخلی ارائه میدهند، که میتواند در مواقع بروز مشکل بسیار مفید باشد.

- هزینه کمتر: قیمت هاستهای داخلی معمولاً به دلیل عدم وابستگی به ارزهای خارجی، کمتر است و ثبات بیشتری دارد.

- تطابق با قوانین داخلی: با استفاده از هاست ایران، بهتر میتوانید قوانین و مقررات محلی را رعایت کنید، بهویژه برای سایتهای تجاری یا سایتهایی که با اطلاعات حساس کاربران سروکار دارند.

- کاهش زمان تأخیر (Latency): میزبانی وب در سرورهای داخلی به دلیل کاهش مسیر انتقال داده بین کاربر و سرور، تأخیر را کاهش میدهد، که به تجربه کاربری بهتری منجر میشود.

با این مزایا، خرید هاست وردپرس ایران میتواند به بهبود عملکرد و امنیت سایت شما کمک کند و از هزینههای اضافی جلوگیری کند.

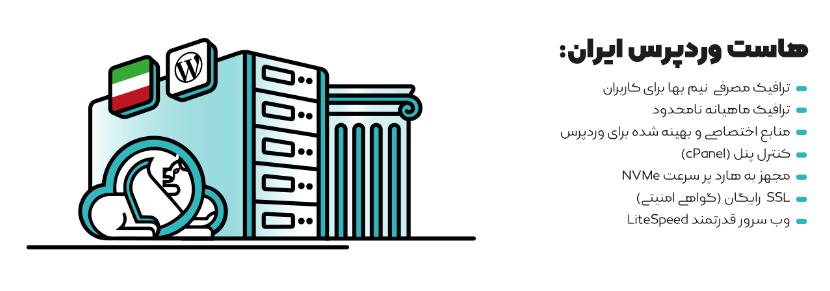

مزایای خرید هاست وردپرس ایران سرورستاپ

خرید هاست وردپرس ایران سرورستاپ مزایای خاصی دارد که میتواند تجربه میزبانی وب سایت شما را بهبود بخشد. برخی از مزایای خرید هاست وردپرس از سرورستاپ عبارتند از:

- سرعت بالا و بهینهسازی برای وردپرس: هاست وردپرس در سرورستاپ با استفاده از سرورهای بهینهشده برای وردپرس، سرعت لود بالاتری ارائه میدهد. این بهینهسازیها شامل کشینگ، استفاده از دیسکهای SSD و کانفیگهای خاص است که منجر به عملکرد بهتر وبسایت میشود.

- پشتیبانی حرفهای: سرورستاپ به عنوان یک ارائهدهنده داخلی، پشتیبانی سریع و حرفهای به زبان فارسی ارائه میدهد. این ویژگی به ویژه برای کاربرانی که به رفع مشکلات سریع نیاز دارند، بسیار اهمیت دارد.

- امنیت بالا: هاست وردپرس ایران سرورستاپ با استفاده از ابزارهای امنیتی پیشرفته، مانند فایروالهای تخصصی، مانع از حملات DDoS و سایر تهدیدات میشود. همچنین بهروزرسانیهای مداوم برای حفاظت از وبسایتها در برابر آسیبپذیریهای امنیتی انجام میشود.

- سازگاری کامل با وردپرس: سرویسها و سرورها به طور خاص برای وردپرس بهینه شدهاند، بنابراین شما به راحتی میتوانید سایت خود را بدون مشکلات سازگاری راهاندازی و مدیریت کنید.

- پهنای باند و منابع نامحدود: برخی از پلنهای هاست وردپرس سرورستاپ پهنای باند نامحدود و منابع کافی برای پردازش را در اختیار کاربران قرار میدهد، که به معنی میزبانی بدون نگرانی از محدودیتها است.

- میزبانی در ایران و بهبود سئو: میزبانی سایت در سرورهای داخلی منجر به بهبود سرعت سایت برای کاربران ایرانی و بهینهسازی در موتورهای جستجوی داخلی میشود. این موضوع تأثیر مثبتی بر سئوی وبسایت شما خواهد داشت.

- هزینه بسیار مناسب: اگر بدنبال خرید هاست وردپرس ایران ارزان و اقتصادی هستید، هاست وردپرس ایران سرورستاپ بهترین گزینه است.

با توجه به این مزایا، انتخاب سرورستاپ برای هاست وردپرس میتواند گزینه مناسبی برای کسبوکارها و سایتهای ایرانی باشد.